KI-Systeme erkennen menschliche Emotionen

Fortschritte bei Sensorik, Rechenleistung und KI erlauben es Softwareentwicklern, eine neue Mensch-Maschine-Schnittstelle zu definieren: die Emotionserkennung.

- Frank Puscher

Das autonome Fahren mag sich vom Alltagsbetrieb auf deutschen Straßen noch eine Weile fernhalten, in den Entwicklungslaboren der Autokonzerne laufen die Selbstfahrer längst auf Hochtouren. Und eine der Kernfragen, die man sich derzeit stellt, ist: Wie fühlt sich autonomes Fahren für den ehemaligen Autolenker und dessen Passagiere an?

Bei Nissan setzen sie täglich einem Dutzend Probanden eine Art überdimensionale Spinne auf den Kopf. Sie soll die Aktivitäten in Gehirnarealen messen und anzeigen. Grob vereinfacht sehen die Forscher ein 3D-Modell eines Gehirns, in dem Farbwolken aufbranden und wieder abklingen. Ist die Wolke rot, dann ist das entsprechende Areal im Gehirn aktiv. Wird aus der roten eine weiße Wolke, deutet das auf Stress hin.

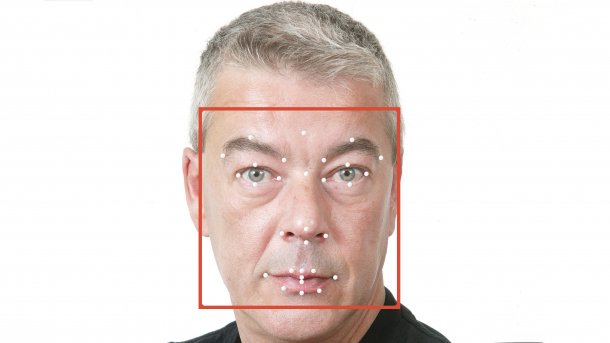

Dieser Stress entsteht beispielsweise, wenn ein Fahrzeug vor einer Kurve "zu spät" bremst. Um das zu simulieren, werden die Teilnehmer mit VR-Brille in einen Fahrsimulator gesetzt. Fahren dürfen sie aber nicht, nur zuschauen. Kameras erfassen nervöse Zuckungen beim Ex-Fahrer, Mikrofone zeichnen die Modulation der Stimme auf und ein EEG misst die Hirnaktivität. Die Analysesoftware verbindet alle Signale und soll so ein möglichst genaues Bild vom emotionalen Zustand des Probanden liefern.