AMDs MI300-KI-Benchmarks: Nvidia meint, H100 sei doppelt so schnell

AMDs kürzliche Ankündigung der Instinct MI300X hat Nvidia aufgeschreckt. Der Chiphersteller reagiert mit eigenen, aktualisierten und optimierten KI-Benchmarks.

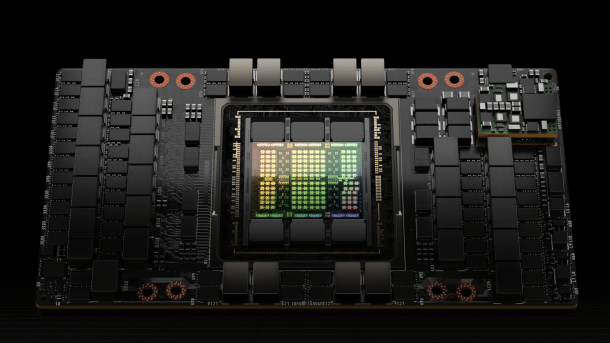

(Bild: Nvidia)

Nvidia hat auf AMDs kürzliche Vorstellung der KI-Beschleuniger MI300X fürs Rechenzentrum reagiert. Allerdings nicht mit neuer Hardware, sondern mit der Behauptung, die hauseigenen DGX-H100-Server mit acht H100-Beschleunigern seien – korrekt konfiguriert – doppelt so schnell wie von AMD angegeben. Da AMD 40 Prozent Vorsprung für sich beansprucht, würde aus Nvidias Werten wiederum folgen, dass ein DGX H100 schneller als ein entsprechender AMD-Server mit acht MI300X wäre.

Vorab noch ein Wort. Wir haben im c't-Labor keinen Zugriff auf Nvidias H100, sodass wir die Werte nicht selbst nachprüfen können. Das wäre eigentlich ein leichtes, denn Nvidia hat in seinem Blogbeitrag ausführlich das durchgeführte Prozedere inklusive der Kommandozeilenparameter zur Kompilierung und Durchführung des Benchmarks dargelegt. Ganz generell lässt sich zumindest Nvidias Teilbehauptung unterstützen, dass für aussagekräftige Benchmark-Vergleiche aktuelle Softwareversionen verwendet werden sollten.

Allerdings hat es in der Hardwarebranche durchaus Tradition, dass Benchmark-Werte der Konkurrenz nicht mit allen zur Verfügung stehenden Optimierungen durchgeführt werden, man denke an die SPEC-Kämpfe zwischen Intel und AMD, die auch juristisch ausgetragen wurden.

Der Stein des Anstoßes: Llama 2

Die Inferencing-Performance eines MI300X-Servers mit acht Beschleunigern soll beim Large Language Modell (LLM) Llama2 mit 70 Milliarden Parametern um 40 Prozent höher sein als bei Nvidias H100, meint AMD und genau in diese Behauptung verbeißt sich Nvidias Blog. Auf die restlichen Leistungsversprechen geht Nvidia mit keiner Silbe ein. Ob das ein stillschweigendes Einverständnis ist, lässt sich schwer sagen, denn in anderen Inferencing-Tests will AMD 60 Prozent und abseits von KI gar noch mehr Vorsprung gegenüber Nvidias H100 beziehungsweise dessen GH200-Version mit zusätzlichem ARM-Prozessor haben.

(Bild: AMD)

Die Fußnote lautet:

MI300-38: Overall latency for text generation using the Llama2-70b chat model with vLLM comparison using custom docker container for each system based on AMD internal testing as of 11/23/2023. Sequence length of 2048 input tokens and 128 output tokens.Configurations: 2P Intel Xeon Platinum 8480C CPU server with 8x AMD Instinct™ MI300X (192GB, 750W) GPUs, ROCm® 6.0 pre-release, PyTorch 2.2.0, vLLM for ROCm, Ubuntu® 22.04.2.Vs. An Nvidia DGX H100 with 2x Intel Xeon Platinum 8480CL Processors, 8x Nvidia H100 (80GB, 700W) GPUs, CUDA 12.1., PyTorch 2.1.0., vLLM v.02.2.2 (most recent), Ubuntu 22.04.3.Server manufacturers may vary configurations, yielding different results. Performance may vary based on use of latest drivers and optimizations.

Was AMD demnach nicht tat und was bei Nvidia offenbar Anstoß erregte, ist die Einbindung von Nvidias TensorRT-LLM, einem Baukasten, um Large-Language-Modelle mittels Python-API für Nvidia-GPUs zu optimieren. Nvidia bietet TensorRT-LLM auf Github an.

Nvidia liefert folgerichtig Testwerte aus dem eigenen Labor nach, muss dafür aber die AMD-Ergebnisse, die nur als Relation zum H100 dargestellt sind, zurückrechnen. Am Ende kommt man zum Ergebnis, dass der Inferencing-Durchsatz bei einzelnen Anfragen (Batch-Size 1) von 3,5 Sekunden pro Anfrage nur 1,7 Sekunden betrage. AMDs zurückgerechnetes Ergebnis läge demnach bei 2,5 Sekunden. Der in der Grafik unten gezeigte Durchsatz ist der jeweilige Kehrwert davon – also 0,285 Anfragen/Sekunde, 0,588 Anfragen/Sekunde und 0,4 Anfragen/Sekunde.

Doch damit nicht genug. Nvidia betont zudem, dass in Rechenzentren eine vorgegebene, akzeptable Latenz von Anfrage zu Antwort üblich sei und man damit die vorhandene Rechenpower viel besser auslasten könne. Entsprechend könne man die Batch-Size, also die gleichzeitigen Anfragen pro Sekunde wählen. Bei 2,5 Sekunden erlaubter Latenz zum Beispiel erreiche der DGX H100-Server rund 5,6 Anfragen/Sekunde, beinahe 10-mal mehr als bei Einzelanfragen. Wie AMDs MI300X-Server mit solchen Parametern skaliert hätte, bleibt freilich offen.

(Bild: Nvidia)

Am Ende bleibt angesichts der sonst üblichen Benchmark-Tricksereien ein nur leicht fader Beigeschmack und der Eindruck, dass Nvidia sich von AMDs MI300X durchaus unter Zugzwang gesetzt fühlt. Und bis man mit neuer Hardware – eventuell auf der Hausmesse GTC 2024 – reagieren kann, rückt man seine Benchmark-Ergebnisse in ein besseres Licht.

Update 16.12.2023: AMD wehrt sich gegen Nvidias Unterstellungen und gibt seinerseits erneuerte Benchmarkergebnisse heraus. Durch Verbesserungen und weitere Optimierungen habe man die Ergebnisse gegenüber den bereits gezeigten steigern können und sei im selben Benchmark nun 110 Prozent schneller. Daneben gibt AMD auch Werte gegen Nvidias H100 mit der Bibliothek TensorRT-LLM an. Demnach seien es nach wie vor, oder wieder, 30 Prozent Vorsprung bei gleicher FP16-Genauigkeit. Selbst wenn Nvidias H100 mit geringerer FP8-Genauigkeit liefe, was die Leistung noch einmal deutlich steigert, sei die hauseigene MI300X mit FP16 und vLLM noch minimal schneller in Sachen Latenz.

Auf die Durchsatzwerte bei fester Latenzvorgabe geht AMD jedoch nicht ein. Man freue sich, so der Blogeintrag, weitere Performancewerte bei unterschiedlichen Genauigkeitsstufen zu teilen. Wir freuen uns auf eine Fortsetzung dieses lustigen Spielchens im neuen Jahr.

(csp)