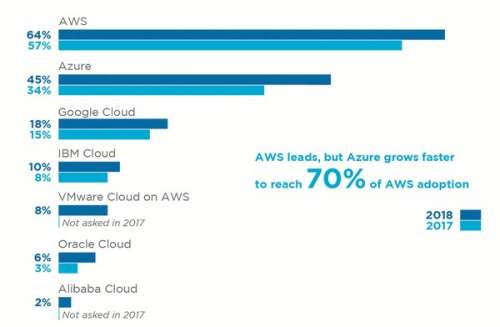

Hosting-Provider profitieren vom Cloud-Boom

Das Beste beider Welten

Haben deutsche Hoster die Flexibilität von Cloud-Providern wie Amazon oder Google zunächst als Bedrohung empfunden, bieten viele von ihnen inzwischen vergleichbare Services in Form von VPS oder Elastic Clouds an. Darüber hinaus nutzen die Hosting-Provider zunehmend selbst die Plattformen AWS oder MS Azure zum schnellen und flexiblen Entwickeln eigener Dienste.

Soll ein externer Cloud-Service oder doch ein Dienst aus der eigenen IT-Abteilung die anstehende Aufgabe lösen? Für die großen Softwareunternehmen ist die Sache klar: Sie reden unisono der Cloud das Wort und viele von ihnen sehen die Zukunft der Software ausschließlich in der Cloud. Unternehmenskunden können die Frage aber nicht immer so einfach beantworten – müssen sie doch gleichermaßen Agilität, Kosten und Datensicherheit unter einen Hut bringen.

Dass es die eine Antwort für die Cloud-Nutzung nicht gibt, zeigen die großen Internetkonzerne: So wechselte der Streaminganbieter Netflix nach und nach von eigenen Servern zu Amazon Web Services (AWS). Den umgekehrten Weg ging der Speicherdienst Dropbox, der seine bei AWS gehostete Software auf eine eigene Infrastruktur verlagerte. Der Grund ist vor allem in unterschiedlichen Geschäftsmodellen zu suchen: Netflix verdient am Content und die Technik dient nur als Mittel zum Zweck. Dropbox offeriert selbst Infrastrukturdienste in Form von Cloud-Speicher, sodass eben hier die Wertschöpfung liegt. Dank AWS gelangte der Service schnell zur Marktreife und lieferte Erfahrungen für den späteren Betrieb eigener Server. 500 Petabyte sprechen eine deutliche Sprache für eine eigene Infrastruktur; Lastspitzen soll aber im Rahmen von etwa 10 % der Daten weiterhin AWS abfedern.

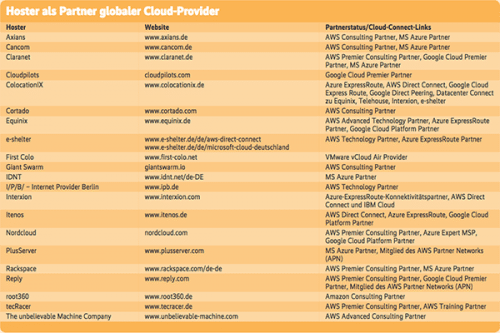

Darüber hinaus optimieren alle Internetanbieter ständig ihre Prozesse und Kosten. So wechselte der Musik-Streamingdienst Spotify von AWS zu Google Cloud. Dass AWS, Google und Microsoft Azure ihren Konkurrenzkampf nicht zuletzt über den Preis austragen, macht es für Anbieter immer interessanter, auf eine eigene Infrastruktur zu verzichten und stattdessen Speicher und Rechenpower aus der Cloud zu nutzen.

Der intensive Wettbewerb fordert bereits prominente Opfer: So hat VMware seinen Infrastrukturdienst vCloud Air einschließlich aller Assets an den französischen Hosting-Provider OVH verkauft. Die Zukunft soll stattdessen in Partnerschaften liegen – neben OVH auch mit Amazon.

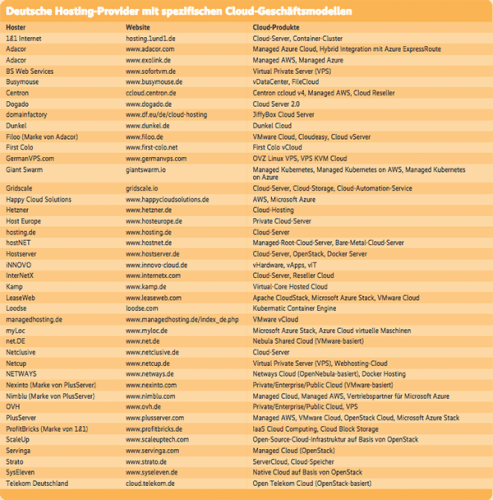

Diese Entwicklung macht vor deutschen Hostern nicht halt. Die einen nutzen selbst Basisdienste der großen Plattformen, andere produzieren vergleichbare virtualisierte Services. Das treibt die Arbeitsteilung unter den Hosting-Providern voran, beispielsweise durch Reseller-Clouds, wie sie InterNetX anbietet. Busymouse positioniert sich inzwischen als reine Channel-Marke und verkauft seine Produkte ausschließlich über Reseller. Auch die Konsolidierung schreitet fort: Seit 2017 gehört Nexinto zu PlusServer und Alfahosting zu Dogado. Die Eigentumsverhältnisse von PlusServer haben sich zudem binnen Jahresfrist geändert: Die Private-Equity-Gesellschaft BC Partners erwarb den Kölner Cloud-Anbieter vom US-Mutterkonzern Go Daddy. 1&1 wiederum übernahm den Berliner Provider ProfitBricks komplett, nachdem die 1&1-Muttergesellschaft United Internet bereits eine Minderheitsbeteiligung gehalten hatte.

Die Cloud um die Ecke

Generell rückt die Cloud immer näher an die Nutzer heran. Wurden zunächst Kunden in ganz Europa aus wenigen zentralen Rechenzentren bedient, so betreiben Amazon, Google und Microsoft mittlerweile mehrere Datacenter in Deutschland. Üblicherweise lassen sie dem Kunden die Wahl, aus welchem Rechenzentrum er einen Dienst in Anspruch nehmen will, wie das bei großen Hostern (Claranet, PlusServer) schon seit Längerem der Fall ist. Hetzner schwimmt gegen den Strom und bewirbt seinen Standort in Finnland damit, dass aufgrund des günstigen Klimas und niedriger Strompreise die Kosten niedriger seien.

Den Kunden bringt die Entscheidung für ein Rechenzentrum gleich mehrere Vorteile: So können sie den Speicherort für die Daten wählen, eigene Redundanzkonzepte realisieren oder Standorte in der Nähe der Nutzer auswählen. AWS ermöglicht sicherheitsbewussten Entwicklern sogar, virtuelle Maschinen auf exklusiv genutzter Hardware laufen zu lassen. Genau genommen entsprechen diese Internetdienste gar nicht mehr dem ursprünglichen Cloud-Paradigma eines Service von „irgendwo“. Ein solcher ist zumindest für personenbezogene Daten innerhalb der EU auch gar nicht mehr zulässig, verlangt doch die im Mai in Kraft getretene Datenschutz-Grundverordnung (DSGVO) konkrete Aussagen darüber, wo die Datenspeicher stehen.

Während die Produkte von Cloud- und Hosting-Providern einander technisch immer mehr ähneln, bleiben doch vertragliche Unterschiede. Maßgeblich ist hier vor allem, welches Landesrecht gilt und wo sich die Unternehmenszentrale befindet.

Für Unternehmen erweist sich immer öfter eine Kombination aus Private und Public Cloud als sinnvoll. Einen vorübergehenden Bedarf decken Cloud-Provider ab, während eine planbare Grundlast günstiger mit eigenen Servern produziert wird – wobei diese nicht notwendigerweise im Firmenrechenzentrum stehen, sondern zunehmend als dedizierte Ressourcen bei einem Hosting-Provider. Welche Dienste im Unternehmensrechenzentrum verbleiben, bestimmen aber nicht nur kommerzielle Faktoren, sondern vor allem der Datenschutz. So entschied sich die Bundesverwaltung zum Realisieren der „Bundescloud“ anstelle für Dropbox für die Open-Source-Software Nextcloud in eigenen Rechenzentren. Nextcloud gibt es auch von Providern als Service.

Ergänzung, nicht Ersatz

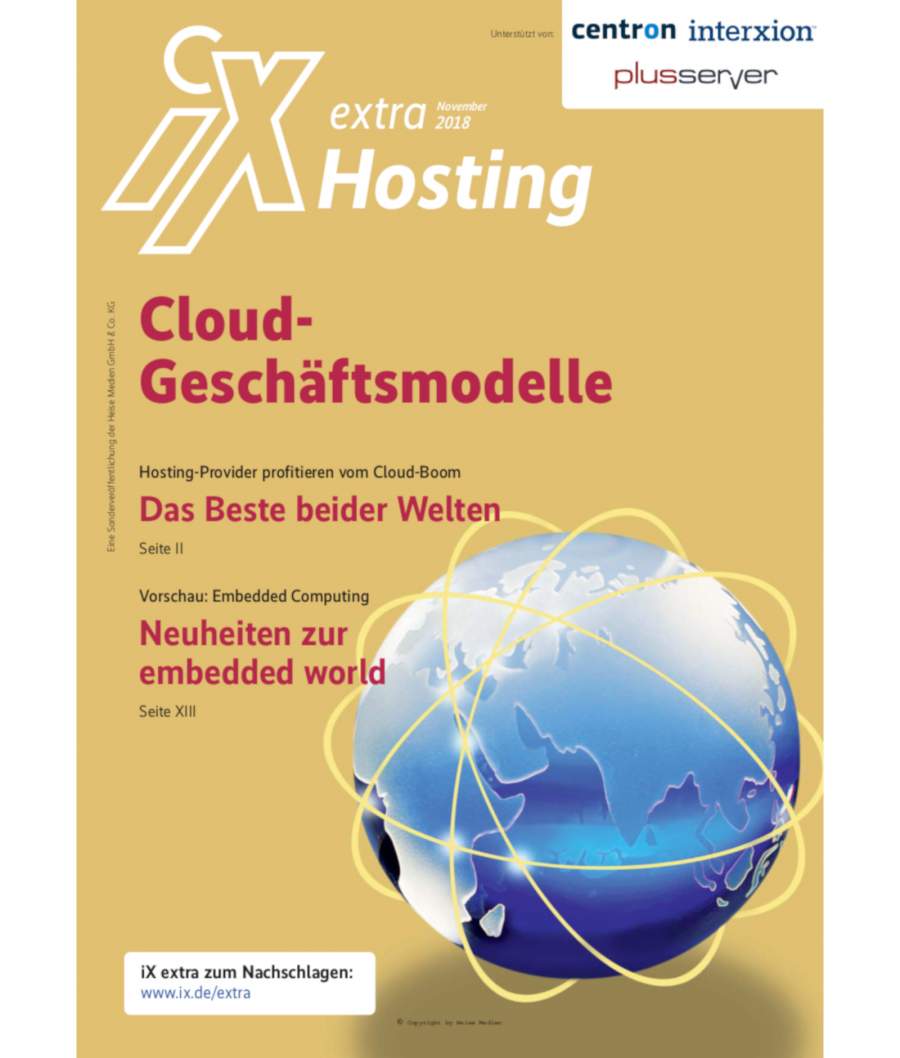

Die Frage „AWS oder Hoster?“ beantworten Unternehmenskunden immer häufiger mit „beides“. Entweder nutzen Provider selbst die AWS-Infrastruktur oder sie bieten Mehrwerte für die AWS-Implementierungen der Kunden. Basis hierfür sind die Partnerprogramme der großen Cloud-Provider. Amazon unterscheidet zwischen vielerlei Arten von Partnern, die sich in Beratungs- und Technologiepartner gruppieren. Microsoft zertifiziert „Azure Solutions Partner“ und „Managed Service Partner“. Google als datenaffines Unternehmen sieht Zertifizierungen als „Application Development Partner“, „Data Analytics Partner“ und „Machine Learning Partner“ vor. Hinzu kommen „Infrastructure Partner“, die ihre Erfahrungen einbringen, um dedizierte Infrastrukturen der Kunden in Googles Cloud zu migrieren. Ein detaillierter Vergleich der Funktionen globaler Cloud-Provider findet sich beim Cloud-Management-Anbieter RightScale (siehe ix.de/ix1811117).

Dass die Softwarestacks von Unternehmen, Hostern und Cloud-Anbietern dank Virtualisierung einander immer stärker ähneln, erleichtert eine Verbindung auf technischer Ebene. Ein Beispiel liefert VMware Cloud on AWS, die seit 2018 auch in Frankfurt am Main zur Verfügung steht. Hierfür werden VMware-Instanzen auf Bare-Metal-Servern von Amazon abgebildet, sodass Unternehmen ihren kompletten VMware-Softwarestack in der AWS-Cloud betreiben können. Damit lassen sich Anwendungen zwischen vSphere im Rechenzentrum und der AWS-Cloud nahtlos verschieben. Zum Steigern der Ausfallsicherheit lassen sich Workloads auch über zwei AWS-Verfügbarkeitszonen hinweg verteilen.

Den entgegengesetzten Weg beschreitet Microsoft mit Azure Stack für lokale Installationen, dessen Funktionsumfang weitgehend dem der Azure-Cloud entspricht. Damit lassen sich Versionen on Premises oder bei einem Provider mit dem Cloud-Service des Herstellers verbinden. Dabei spielt Azure Stack seine Vorteile insbesondere in hybriden Szenarien aus, gestattet er doch die flexible Erweiterung einer Private Cloud um Azure-Ressourcen, beispielsweise als Entwicklungsumgebung, für temporäre Datenanalysen oder als Lastüberlauf. Um den Einstieg zu erleichtern und Kompatibilitätsproblemen vorzubeugen, setzt Microsoft dabei ausschließlich auf vorkonfigurierte Systeme von zertifizierten Hardwarepartnern. Darauf greifen auch Hoster wie MyLoc oder PlusServer zurück, die Azure Stack in ihren Rechenzentren implementieren.

Die Möglichkeit, Instanzen auf die Cloud, Hosting-Provider und das Unternehmensrechenzentrum zu verteilen, beschränkt sich nicht auf Infrastrukturen und Plattformen. Mit Shared Computer Activation (SCA) bietet Microsoft eine solche Verteilung auch für Office 365 an. Besonders interessant ist die Option des Hostings bei einem Provider, verbindet sie doch den Komfort eines Service aus der Cloud mit Datenspeicherung bei einem Partner des Vertrauens. Busymouse stellt SCA für Reseller zur Verfügung, die keine eigenen Kapazitäten aufbauen wollen.

Für kleine und mittelständische Unternehmen ohne ausreichende Kapazitäten im eigenen Haus übernehmen klassische IT-Systemhäuser zunehmend die Systemintegration. Bestand deren Geschäftsmodell bisher vor allem im Verkauf von Hard- und Software, so stellen sie ihren Kunden inzwischen auch eigene Cloud-Plattformen und -Tools zur Verfügung. Ein Beispiel ist der BusinessCloud Marketplace von Cancom für das Verwalten unterschiedlicher Cloud-Applikationen mit nur einem Login (Single Sign-on) und eine aggregierte Rechnungsstellung. Für Systemhäuser steht vor allem die Entwicklung kundenspezifischer Produkte im Vordergrund, die Cloud-Anbieter mit standardisierten Services nicht im Portfolio haben. Zusätzlich bieten sie oft lokale Nähe zu den Kunden, sodass auch Vor-Ort-Services für die Implementierung und Wartung möglich sind.

Das Beste aus allen Welten

Als Weiterentwicklung von Hybrid Clouds propagieren die Anbieter inzwischen Multi-Clouds (auch Multi-Vendor-Clouds). Damit wollen sie zeigen, dass dieser Ansatz mehr als eine Verbindung von Private und Public Cloud bedeutet. Dahinter verbirgt sich ein „Best of Breed“-Ansatz, für jede Aufgabe möglichst die beste Cloud-Lösung auszusuchen (Abbildung 1). Das bedeutet allerdings mehr Aufwand zum Recherchieren, Auswählen und Verwalten mehrerer Verträge und technischer Systeme mittels einer Cloud Management Platform (CMP) wie ManageIQ oder RightScale. PlusServer sieht insbesondere drei Merkmale für Multi-Clouds: Ihre Architekturen enthalten mindestens ein Public-Cloud-System, sie integrieren Private, Public und Hybrid Clouds in beliebiger Kombination und sind über unterschiedliche Anbieter verteilt (Abbildung 2).

Das Ziel besteht darin, dem „Vendor-Lock-in“ vorzubeugen, der Abhängigkeit von nur einem Anbieter. Auch die Verfügbarkeit steigt durch Nutzung mehrerer Provider deutlich – kann diese doch nicht nur technischen Fehlern vorbeugen, sondern auch vertraglichen und geschäftlichen Risiken. Möglich wird das durch die Konvergenz der Virtualisierungsverfahren und produktübergreifende, zum Teil offene Schnittstellen (siehe Kasten).

Auf der anderen Seite führen immer uniformere Produkte (VPS, Elastic Cloud, Container) dazu, dass sich die Anbieter zunehmend über Dienstleistungen und Tools differenzieren müssen. Erfolg versprechende Wege beschreiten auch hier die Großen der Branche, etwa Amazon mit Analytics, das Such-, Analyse- und Business-Intelligence-Funktionen innerhalb von Kundendaten ausführt. Google fokussiert sich ganz aufs Auswerten der Nutzung von Webseiten, Microsoft auf Big-Data-Analyse und Business Intelligence.

Während Hybrid Clouds meist dieselbe Virtualisierungssoftware im Unternehmensrechenzentrum und beim Provider einsetzen, sollen Multi-Clouds unterschiedliche Virtualisierer und Cloud-Modelle (IaaS, PaaS) vereinen. Hieraus ergeben sich aber auch ganz neue Herausforderungen. Eine Hybrid Cloud als homogenes System mit verteilten Daten kann man mit nur einem Management-Tool zentral verwalten. Anders bei Multi-Clouds: Unterschiedliche Cloud-Modelle, Softwarestacks und Hersteller schaffen Insellösungen, die sich nur mit komplexen Orchestrierungswerkzeugen zusammenführen lassen. Da herstellerübergreifende Services ein wesentliches Merkmal von Multi-Clouds sind, ergeben sich ganz neue Interessenlagen der Softwareentwickler. Einerseits wollen sie das eigene Produkt stärken, andererseits müssen sie offen genug sein, im Multi-Cloud-Geschäft mitzuspielen.

Direkter Draht

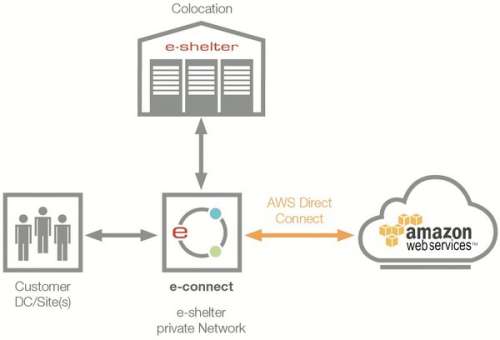

Die dynamische Nutzung von Diensten aus mehreren Clouds stellt auch neue Anforderungen an die Netzwerkverbindungen. Klassischerweise transportiert das öffentliche Internet die Daten, das sich weder bezüglich seines Zeitverhaltens noch seiner Übertragungswege steuern lässt. Dass die Cloud-Rechenzentren näher an die Kunden heranrücken, eröffnet aber die Möglichkeit dedizierter Verbindungen. Unter dem Namen „Cloud Connect“ oder „Direct Connect“ bieten Infrastruktur- und Cloud-Provider immer häufiger direkte Links zwischen ihren Rechenzentren an. e-shelter verbindet so seine Datacenter mit AWS, Interxion auch mit spezialisierten Cloud-Hostern wie Gridscale oder iNNOVO und der IBM Cloud (Abbildung 3). Letztere basiert auf Technologie der 2013 übernommenen Firma Softlayer, die das Bereitstellen von Bare-Metal-Ressourcen, virtuellen Servern und Cloud-Speicher organisiert.

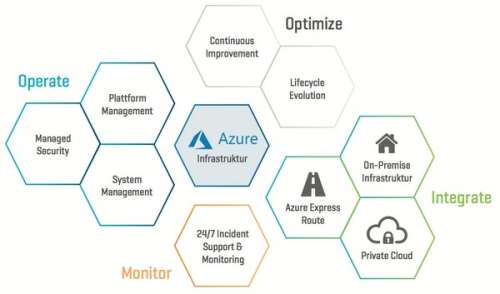

Microsoft positioniert sein Produkt Azure ExpressRoute vor allem für den globalen Zusammenschluss von Datacentern und arbeitet mit internationalen Serviceprovidern zusammen, um Kunden den direkten Anschluss ihrer WANs an die Microsoft-Rechenzentren zu ermöglichen – nicht nur mit dedizierten Leitungen, sondern auch mittels MPLS-VPNs, also paketvermittelter, verschlüsselter Verbindungen. Von den Hosting-Providern mit großen Infrastrukturen in Deutschland unterhalten Equinix, e-shelter, Interxion und Itenos ExpressRoute-Verbindungen zu den Azure-Rechenzentren. So lassen sich Kundeninstallationen on Premises, beim Hoster und in der Microsoft-Cloud verbinden und wie eine einzige Installation managen (Abbildung 4).

Wer direkte Verbindungen zu großen Internetknoten betreibt, kann firmeneigene Rechenzentren direkt an die Standorte von Hostern und Providern anbinden. Am größten deutschen Internetstandort Frankfurt am Main bietet DE-CIX unter dem Namen Direct-CLOUD die Möglichkeit, mit einem Port und nur einem Vertrag virtuelle LANs zu mehreren Cloud-Providern aufzuspannen. Das sichert nicht nur eine berechenbare Bandbreite, sondern verhindert auch Internet-Routing über ausländische Netzknoten. Itenos, die Hosting-Tochter der deutschen Telekom, bietet neben Cloud Connect auch direkte Ethernet-Verbindungen zwischen zwei Lokationen an.

Cloud nutzt Rechenzentren

Aufgrund solcher Entwicklungen verschiebt sich viel Internet-Traffic von klassischen Telcos zu Rechenzentrumsbetreibern, die über eigene Backbones miteinander verbunden sind. Forrester Research prognostiziert allein für das Jahr 2018 die derartige Verlagerung von 10 % der Unternehmensdatenströme.

Wie lukrativ das Cloud-Geschäft sein kann, zeigen die Amazon Web Services, die nur 10 % des Umsatzes von Amazon ausmachen, aber mehr als 70 % zum Geschäftsergebnis beitragen. Das Erfolg versprechende Geschäftsmodell und die niedrige Markteintrittsbarriere führten insbesondere in den USA zur Gründung reiner Cloud-Provider wie Vultr, Digital Ocean oder Kamatera. Alle drei nutzen inzwischen auch Rechenzentren in Frankfurt (Abbildung 5). Gleiches gilt für den Cloud-Pionier Rackspace, der aber primär Infrastructure as a Service anbietet.

Wer keine eigene Technik, sondern die Infrastruktur von Rechenzentrumsbetreibern als Service nutzt, kann schnell und einfach virtuelle Cloud-Ressourcen auf den Markt bringen. Dass in Deutschland kaum spezialisierte Cloud-Provider existieren, liegt vor allem am harten Konkurrenzkampf zwischen mehreren Hundert Hosting-Providern, die ihre Produktpalette selbst in Richtung Cloud-Services erweitern oder verlagern. Eine Ausnahme bildet Gridscale, das als reiner Cloud-Provider anfing und selbst Rechenzentren von Interxion und e-shelter in Deutschland nutzt.

Den Gegenentwurf zu globalen Cloud-Servern implementiert Kamp mit dem Produkt Virtual-Core Hosted Cloud. Hier erhält jeder Kunde dedizierte Hardware, die als virtuelles Datacenter zur Verfügung steht. Sie bietet den Komfort von Cloud-Servern, ohne dass die Ressourcen unter mehreren Kunden aufgeteilt sind. Trotzdem wächst das System mit den Anforderungen durch schnelles Zubuchen weiterer Hardware.

Dynamisches Anpassen von Ressourcen

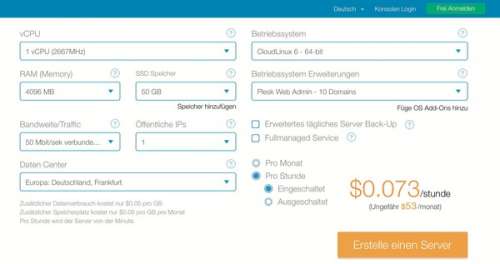

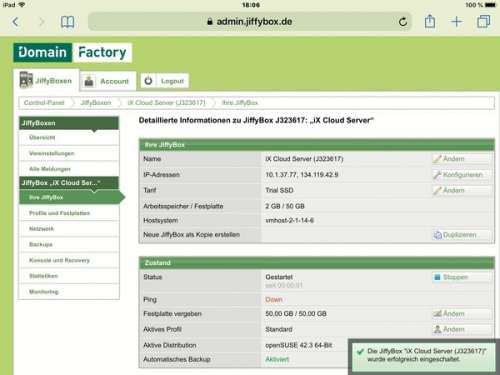

Dreh- und Angelpunkt der Cloud-Produkte von Hosting-Providern sind Virtual Private Server (VPS), oft einfach Cloud-Server genannt. Sie unterscheiden sich technisch nicht von klassischen virtuellen Maschinen, vielmehr stehen die Begriffe für die schnelle und vorübergehende Buchung von Ressourcen und in der Regel auch die Abrechnung nach Zeit. Eindeutig ist die Begrifflichkeit aber nicht, denn auch Hoster mit monatlichen Festpreisen können ihre virtuellen Maschinen Cloud-Server nennen – was ohne Mindestlaufzeit sogar Geld sparen kann. Ein weiteres Merkmal besteht im „Self-Provisioning“, also im Buchen und Einrichten der Server seitens der Kunden (Abbildung 6). Meist stehen VPS sofort bereit: hosting.de nennt gerade einmal 60 Sekunden für die Einrichtung eines Cloud-Servers. Neben grafischen Control-Panels dienen auch Programmierschnittstellen in Form von RESTful APIs dazu, wiederkehrende Prozesse zu automatisieren.

Darüber hinaus eröffnet sich die Möglichkeit der dynamischen Anpassung von Ressourcen an den Bedarf (Elastizität). Hierfür setzt sich allmählich der Begriff Elastic-Cloud-Server durch – in Abgrenzung zu virtuellen Servern, die in Echtzeit konfiguriert, während ihrer Laufzeit aber nicht verändert werden. Allerdings ist die Anpassung von Ressourcen einer einzelnen Instanz in der Regel mit einem Neustart verbunden. Unterbrechungsfrei können das nur Cluster-Konfigurationen gewährleisten. Ressourcen werden automatisiert angepasst (Auto-Scaling). Voraussetzung ist die Definition von Schwellenwerten, bei deren Überschreitung selbstständig neue Instanzen starten. Diese Funktion ist insbesondere dann wertvoll, wenn aufgrund von Ereignissen oder Nachrichten die Zugriffe auf eine Website oder einen Dienst so sprunghaft ansteigen, dass das manuelle Aufrüsten von Ressourcen zu langsam wäre.

Die Flexibilität beim Konfigurieren von Elastic-Cloud-Servern führt dazu, dass sich der Endpreis meist nicht auf einen Blick erfassen lässt, was ein wenig an eine Flugbuchung erinnert. Der Grund liegt in der fein abgestuften Preisgestaltung mit vielen Wahlmöglichkeiten, die auch Mengenstaffelungen und die jeweilige Region berücksichtigt. Neben Extrakosten für zusätzliche Leistungen existieren eine Reihe von Optionen, die zu günstigeren Preisen führen, etwa durch eine längere Vertragsbindung, Nutzung von Restkapazitäten oder Vorauszahlung. Die internationalen Cloud-Provider bestehen zudem nahezu ausnahmslos auf dem Einsatz einer Kreditkarte für die Bonitätsprüfung und Zahlung. Während das in Deutschland auf Unverständnis stößt, ist eine Firmenkreditkarte für den IT-Administrator in den USA die Regel. Hiesige Hosting-Provider halten sich an deutsche Gepflogenheiten und stellen Rechnungen. Eine meist übersichtlichere Produktpalette erleichtert zudem auch solchen Kunden den Einstieg, die noch nicht über viel Administratorwissen verfügen.

Container als Dienstleistung

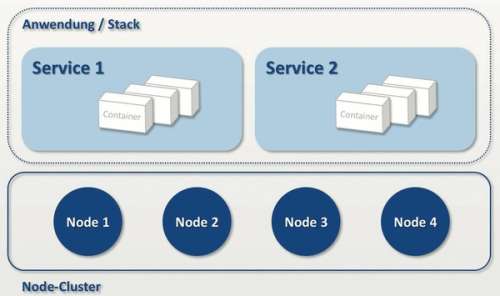

Neben Rechenleistung und Speicherplatz offerieren Cloud-Provider inzwischen auch Container as a Service (CaaS) auf Basis von Docker. Die ursprünglich primär von Entwicklern genutzte Container-Plattform ist dank vielseitiger Managementwerkzeuge reif für den Produktiveinsatz. So beinhaltet CaaS eine komplette Container-Umgebung inklusive Orchestrierungstools, einen Image-Katalog (die sogenannte Registry), eine Cluster-Management-Software sowie ein Set von Entwicklertools und APIs.

Giant Swarm, ein ganz auf Kubernetes spezialisierter deutscher Hoster, nutzt neben lokalen Instanzen die Infrastruktur sowohl von AWS als auch von Azure, während Loodse zusätzlich Digital Ocean oder OpenStack implementiert. So können Kunden ihre Applikationen wahlweise oder gleichzeitig auf ganz unterschiedlichen Plattformen laufen lassen und als Auswahlkriterien Verfügbarkeit, Preis oder lokale Nähe definieren (Abbildung 7).

Die Alternative dazu bilden Hoster, die eine Container-Plattform im eigenen Rechenzentrum betreiben, beispielsweise der 1&1 Container Cluster, der ebenfalls Kubernetes für die Orchestrierung nutzt. Anwendungen lassen sich mittels Cloud Panel über mehrere Server (Nodes) verteilen, die minutengenau abgerechnet werden (Abbildung 8). Mindestens drei Nodes bilden einen Cluster und lassen sich frei in Deutschland, Großbritannien und den USA verteilen. Somit verschwindet der Unterschied zu einem Cloud-Provider. (un@ix.de)