Hardware-Fortschritt pusht KI

Nichts verallgemeinern

CPUs sind zu vielseitig für die üblichen KI-Anwendungen. Deswegen kommen häufig Grafikprozessoren zum Einsatz. Einige Hersteller arbeiten jedoch schon an spezialisierterer Hardware für Machine Learning.

Künstliche Intelligenz ist nichts Neues in der Informatik. Die praktischen Anfänge gehen auf das Computerprogramm Eliza von Prof. Weizenbaum im Jahr 1966 zurück; hohe Erwartungen wurden an die Experten- und Wissensmanagement-Systeme der 80er-Jahre geknüpft. Dann wurde es lange still. Derzeit aber erlebt KI den dritten Hype. Ursache dafür sind nicht nur Fortschritte bei Algorithmen und Softwareengineering, sondern vor allem bei der Hardware.

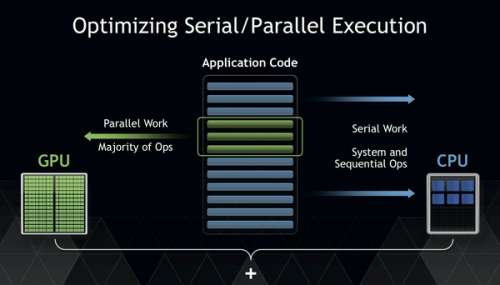

Heute gilt die GPU quasi als die „Gehirnzelle“ der künstlichen Intelligenz. Je mehr dieser Grafikprozessoren ein KI-System hat, desto leistungsfähiger wird es. Denn sie entlasten die normalen Prozessoren des Computers, die bei der Verarbeitung von KI-Workloads schnell an Grenzen stoßen, deutlich. Zudem unterfordern neuronale Netzwerke herkömmliche CPUs, weil sie nur wenige der Befehle aktueller Prozessoren nutzen.

Lernen kostet Zeit

Am meisten Zeit verbringen KI-Systeme mit dem Training, bei dem sie zum Beispiel lernen, Muster zu erkennen. Das lässt sich durch Parallelisierung beschleunigen – und da hat die GPU klar die Nase vorn gegenüber der CPU. Außerdem lassen sie sich viel einfacher in die vorhandene IT-Infrastruktur einbetten als etwa Quantencomputer oder neuromorphe Systeme, die als Alternativen gehandelt werden, sich aber erst im Prototyp-Stadium befinden. Allerdings eignen sie sich nicht für alle Szenarien gleichermaßen gut. Darin liegt ein Motiv, speziellere Alternativen zu entwickeln.

Derzeit werden die KI-Geschäfte immer lohnenswerter; laut IDC soll der Umsatz mit KI- und Cognitive Systems im vergangenen Jahr um fast 60 Prozent auf 12,5 Mrd. Dollar gewachsen sein. Nach Einschätzung der Marktforscher werden diese hohen Wachstumsraten auf absehbare Zeit anhalten; sie prognostizieren ein jährliches Wachstum bis 2020 um 54,4 Prozent durchschnittlich auf dann mehr als 46 Mrd. Dollar Jahresumsatz weltweit. Aus diesem Grund sind einige Grafikboards bereits für ihren üblichen Zweck – den schnellen Bildaufbau in Spielecomputern – kaum noch zu bekommen, zumal auch die Kryptowährungs-Miner viele GPUs kaufen.

Da liegt natürlich für Hersteller die Idee nahe, spezielle KI-Chips zu entwickeln, die auf viele klassische Prozessorinstruktionen verzichten, nur noch die wirklich notwendigen KI-Funktionen bieten und gleichzeitig besonders leistungsfähig sind. Außerdem lässt sich damit eventuell die Dominanz des Marktführers NVIDIA beenden, auch wenn der seinerseits an solchen speziellen KI-Chips arbeitet. Auch die sich langsam aus den Entwicklungslabors vortastenden Quantencomputer wären eine (kostspielige, dafür aber vielleicht hochperformante) Alternative; neben kleinen Pionieren wie D-Wave forschen auch die Global Player an derartigen Systemen, allen voran Google, Microsoft, Intel und IBM.

Deep-Learning mit NVIDIA

Praktisch alle führenden Serverhersteller nutzen heute Tesla- oder Volta-GPUs von NVIDIA, um ihre Systeme für KI- oder Analytics-Anwendungen aufzumotzen. Denn Grafikprozessoren können aufgrund ihrer massiv-parallelen Architektur aus Spezialprozessoren viele der nötigen Aufgaben gleichzeitig übernehmen.

Der japanische Konzern Fujitsu beispielsweise baut die Volta-GPUs als „KI-Acceleratoren“ in einige seiner x86-Server der Primergy-Familie ein – mit nativer GPU-Unterstützung über eine direkte Verbindung zum Mainboard. Verbunden entweder über Plug-in-PCIe-Karten oder über die High-Speed-Option NVlink eröffnen die Server dann laut Hersteller bei Deep Learning ein Performancepotenzial von über 100 Billionen Fließkommaoperationen pro Sekunde (TFlops). Die ersten Modelle mit nativem GPU-Support sind die Server CX2570 M4 und RX2540 M4. Das Chassis des CX400 M4 soll die Dichte und Effizienz Blade-artiger Server unter einen Hut bringen mit den Kostenvorteilen und der Einfachheit Rack-basierter Systeme, während das Modell RX2540 M4 ein Dual-Socket-Rack-Server im Format von zwei Höheneinheiten ist. Durch die GPUs soll er jetzt zusätzlich KI-Anwendungen bedienen können. Der chinesische Hersteller Inspur verspricht mit dem Supercomputer AGX-2 AI mit einer Xeon-CPU und acht Tesla-GPUs gut 170 TFlops.

Auch Dell EMC will bis zum Sommer neue KI-Ready-Bundles mit aktuellen Tesla-Grafikprozessoren und Xeon-CPUs auf den Markt bringen, die High Performance Computing und Datenanalyse mit KI verbinden sollen – für Anwendungen in Bereichen wie Betrugserkennung, Bildverarbeitung, Finanzanalyse oder personalisierte Medizin. Die Bundles kombinieren vorab getestete und validierte HPC-Servermodelle (Power Edge C4140) sowie Storage, Netzwerkkomponenten und Services, die laut Dell durch ihr verschachteltes GPU-Design speziell für Cognitive Computing und Deep Learning optimiert sind.