Mainframe- und Cloud-Computing zusammenführen

Hand in Hand

Den Mainframe zugunsten der Cloud abzuschaffen, ist längst keine Option mehr. Stattdessen muss man Mainframe und Cloud sinnvoll kombinieren.

Mehr als die Hälfte ihrer kritischen Anwendungen betreiben 46 Prozent der Unternehmen in Deutschland auf dem Mainframe. Das geht aus der Forrester-Studie „Modern Mainframe KPIs Are Key To A Successful Digital Strategy“ hervor. Und entgegen einer noch bis 2017 vorherrschenden Meinung geht es heute nicht mehr darum, den Mainframe gänzlich abzulösen. Viel zu hoch ist das Risiko eines Ausfalls und der damit verbundenen Schäden – auf Image-Ebene und finanziell.

Laut Gartner kann der Stillstand eines IT-Systems rund 300 000 Euro pro Stunde kosten. Entsprechend skeptisch sind Unternehmen, wenn es darum geht, hochkritische Geschäftsanwendungen aus diesem Umfeld herauszulösen. Denn in Sachen Ausfallsicherheit und Leistungsfähigkeit ist und bleibt der Mainframe die führende Plattform.

Aus Sicht der betreffenden Unternehmen ist die Skepsis gegenüber einer Ablösung des gewohnten Großrechners zugunsten von Cloud-Strukturen also durchaus nachvollziehbar. Denn insbesondere Branchen wie Handel, Banken und Versicherungen, die intensiv auf den Mainframe setzen, wickeln in ihren geschäftskritischen Applikationen hohe Transaktionszahlen ab, die die sogenannten ACID-Eigenschaften erfüllen müssen.

Zur Erinnerung: ACID steht für Atomicity, Consistency, Isolation und Durability – die vier Grundprinzipien, denen alle Transaktionen in IT-, Datenbankmanagement- und verteilten Systemen laut ISO-Standard folgen müssen.

Transaktionssicherheit gefragt

Atomarität erfordert, dass eine Transaktion, die mehrere Informationsteile beinhaltet, entweder komplett oder gar nicht ausgeführt wird. Die Transaktion muss immer als Einheit bestehen bleiben. Konsistenz bedeutet, dass eine Transaktion jedes Mal einen neuen gültigen Datenzustand generiert. Tritt an irgendeiner Stelle ein Fehler auf, müssen die Ursprungsdaten regeneriert werden, damit keine fehlerhaften Datensätze entstehen. Bei dem Grundsatz der Isolation geht es darum, eine noch nicht ausgelieferte Transaktion im Prozess von anderen Transaktionen zwingend abzuschirmen. Darüber hinaus verlangt die Dauerhaftigkeit, die Daten nach Abschluss einer erfolgreichen Transaktion so zu speichern, dass sie jederzeit im korrekten Zustand zugänglich sind – selbst im Falle eines Fehlers oder Systemneustarts.

Diese anspruchsvollen und komplexen Anforderungen erfüllt der Mainframe wie keine andere Plattform. Wie bedeutend diese Leistung ist, verdeutlichen Daten von Statista aus der Finanzbranche: Im Jahr 2016 wurden weltweit geschätzt etwa 472,6 Milliarden Transaktionen im bargeldlosen Zahlungsverkehr getätigt. Für das Jahr 2020 rechnen die Experten mit 725,8 Milliarden.

Dabei wird vor allem ein Aspekt deutlich, der gegen die Verschiebung solcher Prozesse in die Cloud spricht: die dauerhaft hohe Transaktionsrate. Cloud-Infrastrukturen sind dort lukrativ, wo man schwankende Rechenkapazitäten benötigt und die Leistung sich an das tatsächliche Volumen anpassen muss. Bei konstantem Operationsvolumen fallen insbesondere die preislichen Vorteile der Cloud weg.

Keine Cloud für Banken, Versicherungen & Co.?

Dennoch gibt es auch im Handel, in Banken und Versicherungen sowie in all den anderen Branchen, die Mainframes als Basis einsetzen, ein nicht zu unterschätzendes Cloud-Potenzial. Der Weg führt über die Modernisierung der Applikationsstruktur und die Festlegung der Rechnerleistungen, die für die Cloud geeignet sind. Dazu gilt es im ersten Schritt, monolithische Applikationen zu analysieren und zu zerlegen. Je detaillierter die Analyse des Istzustands, desto besser kann anschließend die Bewertung erfolgen, ob und in welcher Form eine Transformation in die Cloud möglich ist.

In einem Ablaufplan werden alle notwendigen Maßnahmen definiert: Welche Anwendungen aus der Cloud kommen und welche klassisch auf dem Mainframe bleiben sollen; welche Applikationen vor der Transformation zu modernisieren sind und welche direkt migriert werden können. Auch die passende Cloud-Form – Public, Private oder hybrid – legt man hier fest. Der gemischte Einsatz von zOS, zLinux und verteilten Systemen ist hier oft das Zielszenario. Auf Basis all dieser Informationen können Unternehmen anschließend die Transformations- und zukünftigen Betriebskosten kalkulieren und in die Detailplanung einsteigen.

Neben den Applikationen sind auch die Prozesse auf ihre Cloud-Kompatibilität zu prüfen. Dafür geeignete Abläufe lassen sich beispielsweise sukzessive in Java-Microservices überführen. Doch auch dazu ist im ersten Schritt eine detaillierte Analyse notwendig.

Was Macro-, Micro- und REST-Services unterscheidet

Grundsätzlich unterscheidet man im Transaktionsumfeld Macroservices, Microservices und REST-Services. Macroservices sind langlaufende Batch-Prozesse mit besonders vielen Transaktionen. Diese benötigen besonders leistungsstarke Plattformen mit höchster Performance und sind daher optimal im klassischen Mainframe-Umfeld (Java, COBOL, DB2, zOS) aufgehoben.

Microservices sind kleinere Prozesse mit variablen Transaktionsraten. Aufgrund ihrer Flexibilitätsanforderungen können sie beispielsweise in der zLinux-Cloud betrieben werden, die wegen der gemeinsam genutzten Hardware optimale Zugriffe auf die Daten ermöglicht.

Über die RESTful API oder REST-Services werden die Prozesse für Java-Entwickler verfügbar gemacht, die über die Cloud auf die notwendigen Informationen zugreifen können. Übertragen in die Praxis bedeutet dies beispielsweise im Finanzsektor, die Macroservices decken die Transaktionen zwischen Konten, Überweisungen und digitalen Geldflüssen ab. Das sind Prozesse mit dauerhaft hohen Transaktionsraten, die eine besonders leistungsfähige, stabile und sichere Plattform benötigen.

Zu den Microservices zählen beispielsweise Dialogprozesse mit den Kunden zur Terminvereinbarung oder zur Klärung allgemeiner Fragen. Diese schwanken in ihrer Intensität und sind bei Weitem nicht so sicherheitsrelevant wie Kontobewegungen. Entsprechend können sie über Cloud-Dienste abgewickelt werden. Besonders flexibel lassen sich REST-Services wie der Abruf des aktuellen Kontostandes via App abbilden.

Mit der Fokussierung auf Cloud-Computing und die ursprünglich geplante Ablösung der Großrechner gerieten in den letzten Jahren Mainframe-Know-how und -Weiterentwicklung ins Hintertreffen. Nachdem lange Zeit Fort- und Weiterbildungen sowie technische Neuerungen vernachlässigt wurden, stehen Unternehmen jetzt vor einer Kompetenzlücke.

Neues Großrechner-Know-how gefragt

Experten für die modernen Großrechnertechniken wie zLinux, WebSphere Liberty, grafische COBOL-Code-Analyse und moderne Entwicklungsumgebungen fehlen häufig. Die wenigen noch vorhandenen Mitarbeiter kennen sich zumeist höchstens noch mit den klassischen Mainframe-Umgebungen wie COBOL und zOS aus.

Um Applikationsmodernisierungen unter diesen Voraussetzungen möglich zu machen, braucht es einen belastbaren Transformationsprozess. Dieser startet idealerweise mit einer Analyse der aktuellen IT-Landschaft sowie der Applikationen. Im Anschluss sollten sämtliche eingesetzten Methoden und Tools sowie die Qualifikationen des bestehenden Teams bewertet werden. Aus diesen Informationen entsteht ein transparentes Bild der aktuellen Situation als Basis für potenzielle Modernisierungsmaßnahmen.

Doch bevor es an die Umsetzung gehen kann, lohnt sich die Entwicklung eines Konzeptes der angestrebten Architektur und eine Modernisierungsstrategie für alle betroffenen Bereiche. Dazu gehört die langfristige Aufstellung der verantwortlichen Teams, die schrittweise Modernisierung der Applikationen durch das Aufbrechen von Monolithen genauso wie die evolutionäre Umstellung auf den modernen Mainframe-Stack.

Darüber hinaus spielt auch die Einführung moderner, agiler Entwicklungsmethoden wie DevOps eine wichtige Rolle. Der eigentliche Umsetzungsprozess sollte dann von der Machbarkeitsstudie bis zur Transformation der geschäftskritischen Applikationen Schritt für Schritt sauber geplant und professionell umgesetzt werden – je nach eigenem Know-how auch mit Unterstützung eines erfahrenen externen Expertenteams. So entstehen schnelle, einfache Verbesserungen ebenso wie eine langfristige, nachhaltige Modernisierung auf allen Ebenen.

Strategisch fit für Innovationen

Mit der Modernisierung wird der Mainframe zur strategischen IT-Plattform. Er überzeugt durch hohe Leistung, Stabilität und Sicherheit – nicht nur für die bestehenden Applikationen. Auch innovative Themen können auf Basis der modernen Großrechner in die Realität umgesetzt werden. Machbarkeitsstudien und Pilotprojekte gibt es bereits.

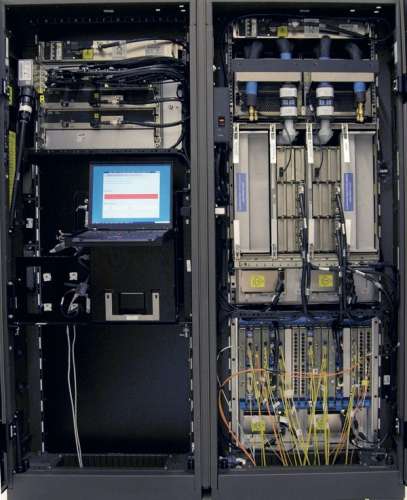

Mit der Entwicklung vom Wasserfallmodell hin zu Agile, Scrum und DevOps sowie der Überführung von COBOL in die Java-Welt entsteht ein an die Cloud angebundener Mainframe. Er bietet das ideale Fundament für Blockchain, IoT und künstliche Intelligenz, denn in all diesen Fällen sind enorme Rechenleistungen und die zuverlässige Durchführung unzähliger Transaktionen gefragt. Mainframe-Systeme haben die Ressourcen, Blockchain-Mechanismen auf ein neues Level zu heben: umfangreichen Speicher für Rechenoperationen, extrem leistungsfähige Prozessoren, ein hochskalierbares I/O-System. Und ein optimiertes Netzwerk zwischen virtuellen Systemen innerhalb des Mainframes beschleunigt die Peer-to-Peer-Kommunikation. Ein einzelner zSystems-Großrechner von IBM kann pro Tag bis zu zweieinhalb Milliarden Transaktionen durchführen.

In die Hardware implementierte Security, Ende-zu-Ende-Verschlüsselung sowie Containertechnik sorgen für das nötige Sicherheitsniveau. Das kann auch in IoT-Projekten den entscheidenden Vorteil bieten: 21 Milliarden vernetzte Geräte sollen laut Gartner im Jahr 2020 im Einsatz sein. Die daraus entstehenden unzähligen Informationen und die notwendige Kommunikation zwischen diesen teilweise intelligenten, vernetzten Dingen müssten extrem schnell, zuverlässig und sicher verarbeitet und transportiert werden. Mainframes sind hier die ideale Lösung.

Fazit

Großrechner sind und bleiben das Rückgrat der IT-Systeme transaktionsintensiver Geschäftsmodelle. Zur Einhaltung der ACID-Eigenschaften gibt es keine bessere Plattform und auch für Innovationsthemen bietet der Mainframe die ideale Basis. Die Verbindung zur Cloud gelingt über Modernisierung, Applikationsweiterentwicklung und die Definition transformationsfähiger Prozesse. In der Kombination aus Mainframe und Cloud entsteht eine zukunftsfähige IT-Infrastruktur, die die wesentlichen Faktoren Sicherheit, Stabilität, Leistungsfähigkeit, Geschwindigkeit und Agilität ideal zusammenbringt. (js@ix.de)